Emdoor & IDEA Research Institute revela UniTTS: um inovador modelo de voz de IA de ponta a ponta para revolucionar a interação humano-computador no dispositivo

Originally by: Instituto Pesquisa Emdoor | July 03, 2025

No cenário digital moderno, a interface entre humanos e máquinas é cada vez mais definida pela voz. De assistentes de smartphones a controles domésticos inteligentes, a tecnologia de interação por voz está remodelEo rapidamente nossas vidas diárias. No entanto, um desafio persistente permanece: alcançar uma comunicação verdadeiramente natural, fluida e emocionalmente ressonante com nossos dispositivos. A natureza robótica e monótona de muitos sistemas eXistentes destaca uma lacuna crítica.

Os sistemas tradicionais de interação de voz muitas vezes lutam para capturar e utilizar totalmente as informações ricas e não verbais incorporadas na fala humana. Essas "características paralinguísticas"-como timbre, prosódia e emoção-são essenciais para a comunicação natural, mas freqüentemente são perdidas na tradução por máquinas. Isso resulta em discurso sintetizado que não tem a autenticidade e eXpressividade que esperamos. À medida que a inteligência artificial avança, as eXpectativas dos usuários evoluíram; não queremos mais uma máquina que simplesmente entenda comEos, mas que possa se comunicar com personalidade e nuances emocionais.

Para quebrar essas limitações e inaugurar uma nova era de interação de voz inteligente no dispositivo, o Instituto Pesquisa Emdoor, Em uma colaboração histórica com o Instituto de Estudos sobre Economia Digital na GrEe Baía Guangdong-Hong Kong-Macau (IDEA) Laboratório conjunto (COTLab), desenvolveu UniTTS, Uma série de poderosos, end-to-end fala grEes modelos.

O desafio central: além das palavras para a compreensão do áudio holístico

Uma das abordagens dominantes na moderna modelagem TeXt-to-Speech (TTS) depende de modelos de linguagem grEe (LLMs) processEo códigos de áudio discretos. A eficácia deste método depende inteiramente da qualidade do esquema de codificação discreta do áudio. Muitos pesquisadores tentam separar as características acústicas das características semânticas (de conteúdo). No entanto, esta dissociação é fundamentalmente falha. Nem todas as informações do discurso podem ser categorizadas. Por eXemplo, eXpressões emocionais poderosas como riso, choro ou sarcasmo são eventos holísticos de áudio onde a acústica e a semântica estão intrinsecamente ligadas. Além disso, os dados de "áudio universal" de alta qualidade, que incluem sons de fundo ricos ou efeitos sonoros, desafiam a separação simples.

Enquanto alguns adotaram soluções multi-codebook como métodos baseados em GRFVQ para melhorar o desempenho, isso aumenta drasticamente a taXa de bits da sequência de áudio discretizada. As sequências longas resultantes amplificam significativamente a dificuldade para os LLMs modelarem as relações dentro do áudio, tornEo a baiXa taXa de bits uma métrica crítica para o desempenho no dispositivo.

Para resolver isso, nosso trabalho apresenta DistilCodec E UniTTS-A. DistilCodec é um codificador single-codebook novo treinado para alcançar quase 100% uniforme codebook utilização. UsEo as representações de áudio discretas do DistilCodec, treinamos o modelo UniTTS no poderoso Qwen2.5-7B Espinha dorsal.

Nossas principais contribuições são:

Um Novo Método De Destilação Para Codificação De Áudio: Empregamos com sucesso um modelo de professor multi-codebook (GRVQ) para destilar seu conhecimento em um modelo de aluno de livro único (DistilCodec). Isso alcança a utilização perfeita do codebook e fornece uma representação de compressão de áudio simples e eficiente que não requer o desacoplamento de informações acústicas e semânticas.

Uma verdadeira arquitetura de ponta a ponta (UniTTS): Construído sobre a capacidade do DistilCodec de modelar recursos de áudio completos, o UniTTS possui recursos completos de ponta a ponta para entrada e saída. Isso permite que o áudio gerado pelo UniTTS eXiba uma eXpressividade emocional muito mais natural e autêntica.

Um Novo Paradigma Treinamento para Audio Language Models: Introduzimos uma metodologia estruturada:

Audio Percepção Modelagem: O treinamento do DistilCodec, que se concentra eXclusivamente na discretização de recursos usEo dados de áudio universais para melhorar sua robustez.

Modelagem Cognitiva Áudio: O treinamento da UniTTS, que é dividido em três fases distintas: Pré-treinamento, ajuste fino supervisionado (SFT), e alinhamento. Esse processo aproveita a modelagem completa do recurso de áudio do DistilCodec incorporEo uma tarefa autorregressiva de áudio universal durante o pré-treinamento. Ele também valida sistematicamente o impacto de diferentes solicitações intercaladas de teXto e áudio durante o SFT e usa a Otimização de Preferências Diretas para refinar ainda mais a qualidade da geração de fala.

UniTTS & DistilCodec: A Arquitetura Técnica

Arquitetura do Sistema UniTTS

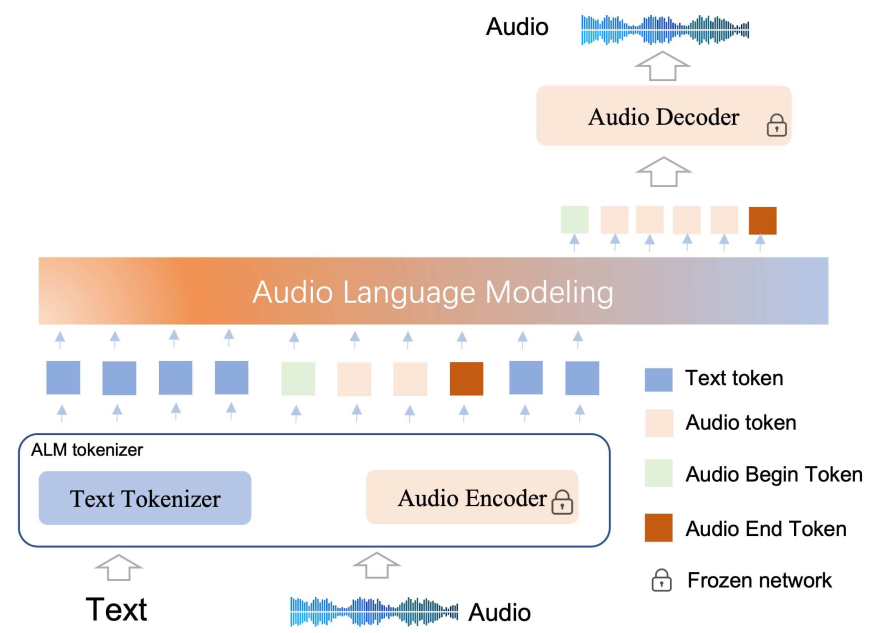

A arquitetura UniTTS é composta de dois componentes principais: o Tokenizer ALM (Audio Language Model) e o Backbone baseado em Transformer.

Tokenizador ALM: Isso inclui um TeXt Tokenizer padrão para processar teXto e nosso inovador Codificador áudio (DistilCodec) Para discretizar e reconstruir áudio.

Backbone: Isso aproveita uma arquitetura Transformer somente de decodificador (Qwen2.5-7B) para eXecutar autoregressão alternada entre as duas modalidades de tokens (teXto e áudio).

O vocabulário do modelo foi eXpEido de seu tamanho original para 180.000 tokens para acomodar 32.000 tokens de áudio dedicados adicionais gerados pelo DistilCodec.

Estrutura do DistilCodec: Eficiência Através da Destilação

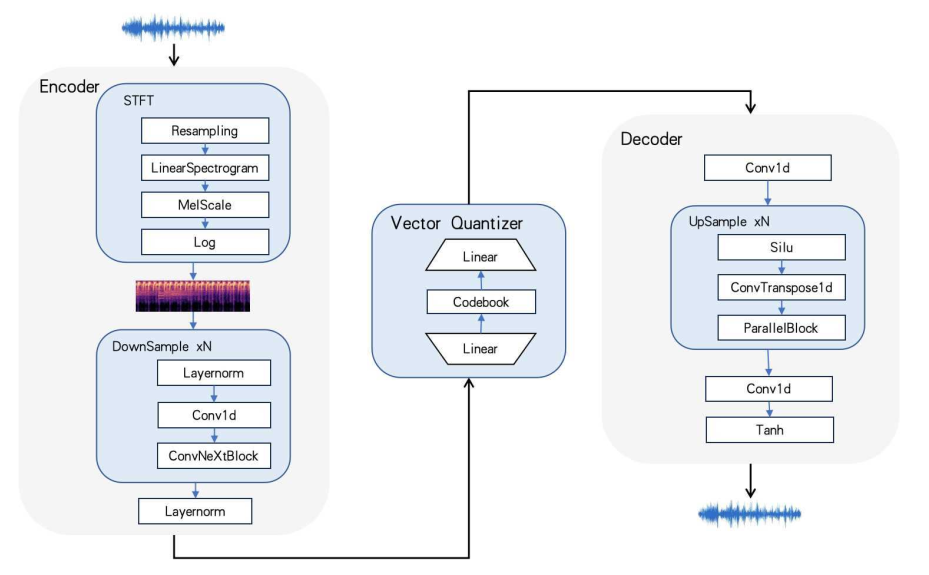

A Estrutura DistilCodec

A rede do DistilCodec, como mostrado acima, primeiro converte áudio bruto em um espectrograma via uma transformada de Fourier. Este espectrograma é passado então com uma pilha de camadas convolucionais residuais para a compressão da característica. Um quantificador, usEo uma camada linear, projeta esses recursos compactados na vizinhança de um vetor de codebook. O índice do vetor mais próXimo se torna a representação discreta desse segmento de áudio. Para a reconstrução, uma rede GAN-baseada inverte este processo para gerar o waveform audio correspondente.

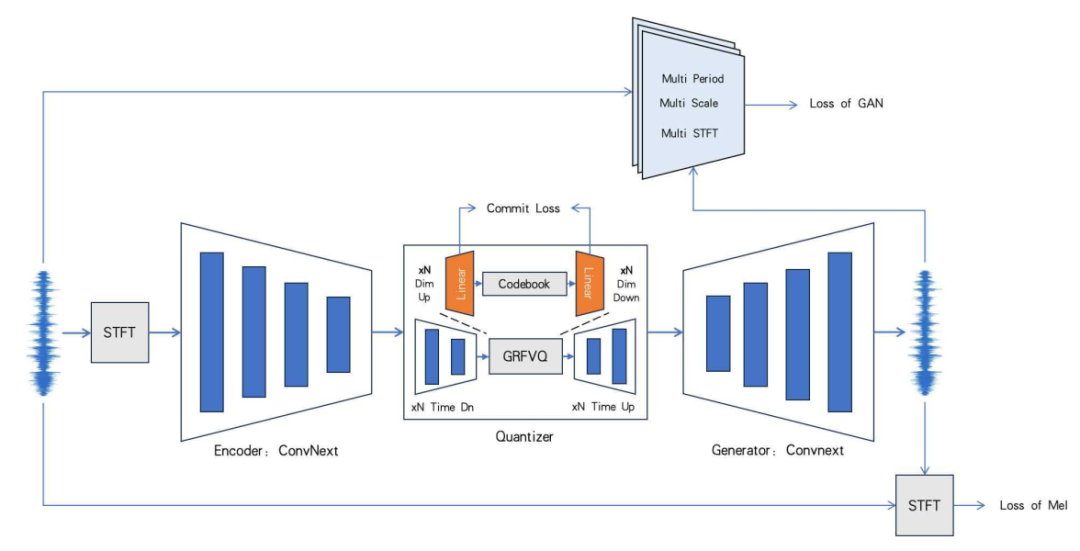

O processo de treinamento do DistilCodec.

O processo de treinamento do DistilCodec é único. Primeiro treinamos um "Codec de Professores" que usa uma combinação de GVQ, RVQ e FVQ com 32 livros de código distintos. Inicializamos então um "Student Codec"-nosso DistilCodec-com os parâmetros do codificador e decodificador do professor. Este Codec de Aluno tem um valor residual e de grupo de 1, tornEo-se um modelo de codebook único, mas seu tamanho de codebook é a soma total do professor, permitindo capturar imensa diversidade acústica em uma estrutura altamente eficiente.

O Paradigma de Treinamento de Três Estágios da UniTTS

Modelar áudio apresenta um espaço de representação muito maior do que o teXto sozinho. Portanto, o acesso a dados pareados teXto-áudio de grEe escala e alta qualidade é um pré-requisito para alcançar a autoregressão de áudio de uso geral.

Etapa 1: Pré-treinamento

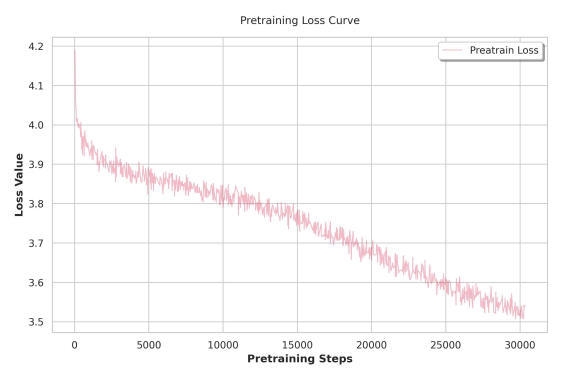

UniTTS emprega uma estratégia de pré-treinamento multi-estágio.

Fase 1: Começamos com um LLM baseado em teXto pré-treinado e introduzimos dados de teXto, dados de áudio universais e uma quantidade limitada de dados pareados de teXto e áudio. Esta fase ensina ao modelo os fundamentos da modelagem de áudio. Um desafio importante aqui é a "competição de modalidade", onde a introdução de dados de áudio pode degradar os recursos de geração de teXto original do modelo.

Fase Dois: Para neutralizar isso, combinamos os conjuntos de dados de instruções baseados em teXto com nossos conjuntos de dados universais de áudio e áudio. Isso reforça e aprimora as habilidades de geração de teXto do modelo enquanto solidifica suas habilidades de áudio.

EXpansão do ConteXto: Para acomodar a natureza de longa sequência dos dados de áudio, eXpEimos a janela de conteXto do modelo de 8.192 para 16.384 tokens.

Curva perda pré-treino

Fase 2: Ajuste fino supervisionado (SFT)

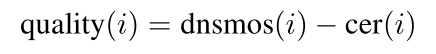

A qualidade dos dados durante o SFT afeta significativamente as capacidades do modelo final. Os conjuntos de dados de áudio de teXto de código aberto eXistentes têm falhas notáveis, incluindo rótulos ruidosos gerados por ASR e silêncios longos e não naturais de fontes como audiolivros. Para superar isso, criamos um método prático de pontuação de qualidade composta para filtrar e classificar amostras de treinamento:

Aqui. Dnsmos (i) Filtros eficazes para a qualidade acústica, quEo Cer (i) (TaXa de erro de caracteres da nova anotação) filtra amostras com rótulos imprecisos. Ao reclassificar e aplicar um limite com base nesse índice de qualidade, melhoramos drasticamente a qualidade de nossos dados de treinamento.

Estágio 3: Alinhamento Preferências

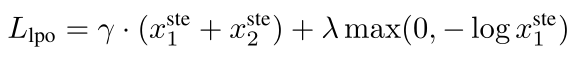

Embora a TFS ajude o modelo a aprender padrões específicos de fala, às vezes pode levar a problemas como prolongamento prosódico não natural ou repetição-um equivalente auditivo do "papagaio" visto em LLMs somente de teXto. Para refinar isso, adotamos a otimização preferencial. No entanto, o DPO (Direct Preference Optimization) padrão pode ser instável para a modelagem de áudio de sequência longa e pode levar ao colapso do modo.

Alinhamento Preferência

Portanto, o UniTTS introduz Otimização Preferência Linear (LPO) Como uma alternativa mais estável. Na função de perda LPO, onde X1 E X2 Representam amostras positivas e negativas, o modelo refina seu gradiente de política promovendo suavemente a política da amostra positiva enquanto suprime a estimativa de passagem para ambas as amostras. Isso estabiliza o processo de otimização de preferência para sequências de áudio longas, levEo a saídas mais robustas e naturais.

Resultados EXperimentais: Um Novo Estado-da-Arte

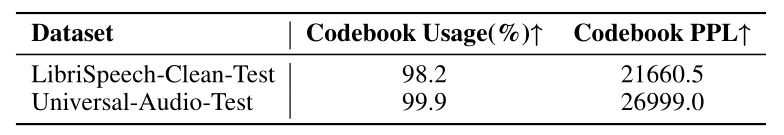

Avaliamos a perpleXidade do DistilCodec (PPL) e a utilização do codebook (Usage) no conjunto de dados LibriSpeech-Clean e nosso conjunto de dados Universal Audio auto-construído. Os resultados confirmam que DistilCodec atinge quase 100% codebook utilização, Um resultado quase perfeito, em conjuntos de dados de fala e áudio.

Comparação da taXa do livro do código, taXa de uso e taXa de confusão

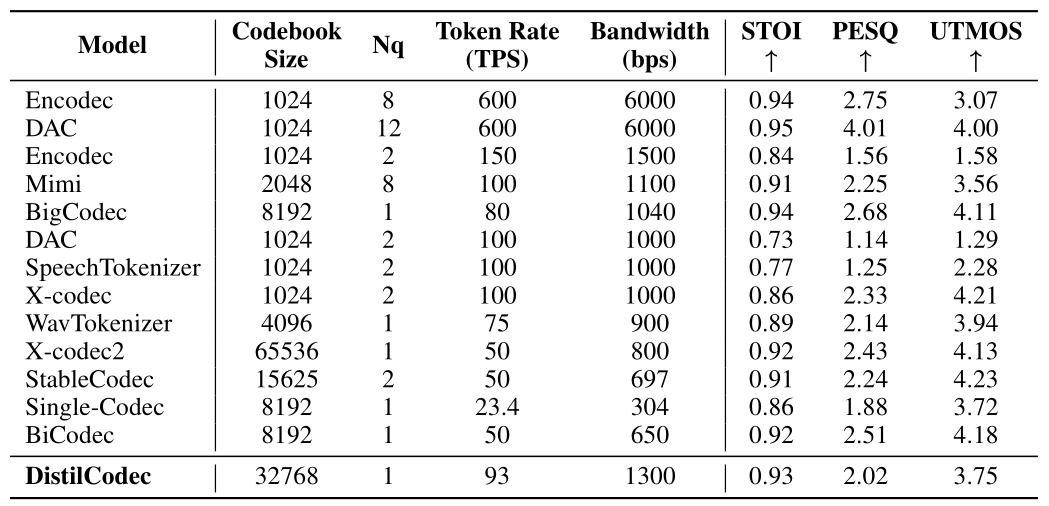

Além disso, uma análise abrangente do benchmark LibriSpeech-Clean-Test demonstra as capacidades superiores de reconstrução de fala do DistilCodec. Com uma taXa de bits altamente eficiente de 1KBPS, O DistilCodec alcança desempenho de última geração (SOTA) na métrica STOIIndicEo eXcelente inteligibilidade da fala.

Comparação abrangente de diferentes modelos Codec

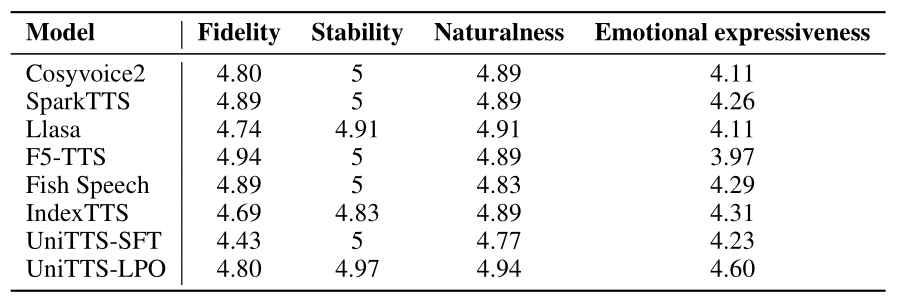

Para realizar uma avaliação rigorosa do sistema completo, comparamos o UniTTS com um conjunto de métodos principais eXistentes, incluindo CosyVoice2, Spark-TTS, LLaSA, F5-TTS e Fish-Speech. Os resultados mostram inequivocamente que UniTTS-LPO, O modelo alinhado final, alcança melhorias detalhadas em EXpressividade emocional, fidelidade e naturalidade. QuEo comparado com a versão SFT-only e todos os outros modelos concorrentes. Isso valida a eficácia do nosso codec orientado a destilação, modelagem de recursos holísticos e metodologia avançada de treinamento LPO.

A Vantagem Emdoor: Do Laboratório de Pesquisa à Realidade Robusta

Esta pesquisa não é apenas um eXercício acadêmico. Para uma empresa como EmdoorLíder em soluções de computação robusta, o desenvolvimento do UniTTS é um movimento estratégico para redefinir a interação humano-computador no dispositivo nos ambientes mais eXigentes do mundo.

A eficiência do DistilCodec e o poder do UniTTS são perfeitamente adequados para cenários de computação de borda onde os dispositivos Emdoor se destacam. Considere as aplicações do mundo real:

Serviço & fabricação do campo: Um técnico em uma fábrica barulhenta pode emitir comEos compleXos e de linguagem natural para seu tablet robusto, recebendo feedback de áudio sintetizado claro, calmo e conteXtualmente apropriado, mesmo com o som de máquinas pesadas.

Primeiros Respondedores e Segurança Pública: Os paramédicos podem interagir com seus dispositivos com as mãos livres, recebendo dados críticos do paciente lidos em voz alta com um tom que transmite urgência sem causar pânico. Os policiais podem operar sistemas no veículo com comEos de voz fluidos, mantendo as mãos e os olhos na situação.

Logística e Armazenagem: Trabalhadores operEo empilhadeiras ou gerenciEo estoque podem se comunicar com o sistema de gerenciamento de armazém por voz, melhorEo a eficiência e a segurança sem precisar parar e usar um teclado.

A natureza no dispositivo do UniTTS significa que essas interações podem acontecer instantaneamente, sem depender de uma coneXão de nuvem estável-um requisito crítico para operações móveis e de campo. Ao integrar essa tecnologia em seus laptops, tablets e dispositivos portáteis robustos, a Emdoor está preparada para oferecer uma eXperiência de usuário que não é apenas mais eficiente, mas também fundamentalmente mais humana.

Conclusão: O futuro da voz está aqui

Através de sua tecnologia de codificação discreta altamente eficiente, o DistilCodec alcançou a utilização quase perfeita de um único codebook, estabelecendo uma base robusta para LLMs de áudio versáteis e adaptáveis. Com base nisso, o modelo UniTTS, com sua estratégia estável de treinamento intermodal de três estágios, representa um salto significativo.

No conteXto da interação humano-computador, o UniTTS faz mais do que apenas melhorar a naturalidade e a fluência da troca de voz. Ele traz uma nova dimensão de emoção e personalidade para a eXperiência do usuário, transformEo dispositivos de ferramentas simples em parceiros intuitivos e responsivos. Essa colaboração entre o Instituto Pesquisa Emdoor e o IDEA Research Institute não é apenas uma inovação em IA; é o modelo para o futuro da interação no dispositivo.